Como implementamos seu pipeline?

Processo de desenvolvimento de pipeline de dados em 4 etapas especializadas

Análise de arquitetura detalhada

Avaliamos suas fontes de dados atuais, infraestrutura existente e definimos a arquitetura ideal para seu pipeline personalizado com tecnologias modernas.

Desenvolvimento do pipeline ETL

Criamos pipelines ETL personalizados usando tecnologias líderes como Apache Airflow, Python e SQL para automatizar todo o fluxo de dados.

Implementação e testes robustos

Implantamos o pipeline com monitoramento completo, testes de qualidade, validação de dados e recuperação automática de falhas.

Monitoramento contínuo e suporte

Fornecemos dashboards de monitoramento em tempo real, alertas automáticos e suporte técnico especializado para manutenção contínua.

Vantagens dos pipelines profissionais

Automatize completamente seus processos de dados empresariais

Automação total de dados

Elimine trabalho manual com planilhas e processos manuais. Colete, transforme e carregue dados automaticamente de múltiplas fontes para destinos únicos e confiáveis.

Escalabilidade empresarial ilimitada

Processe desde MBs até PBs de dados com arquiteturas cloud-native que escalam automaticamente conforme demanda sem perda de performance.

Qualidade e confiabilidade garantida

Pipelines com validação automática de dados, tratamento de erros robusto e recuperação de falhas para garantir dados sempre íntegros e atualizados.

Insights em tempo real

Transforme dados brutos em dashboards executivos atualizados automaticamente para decisões estratégicas rápidas e baseadas em dados atuais.

Redução de custos operacionais

Elimine horas de trabalho manual, reduza erros humanos e otimize recursos computacionais com processamento inteligente e eficiente.

Integração completa de sistemas

Conecte todas as suas fontes de dados: CRMs, ERPs, APIs, bancos de dados e planilhas em um fluxo único e automatizado.

Quem precisa de pipelines de dados

Empresas que transformam dados em vantagem competitiva

Empresas de E-commerce

VarejoIntegrem dados de vendas, estoque, marketing e atendimento para visão 360° do negócio e otimização de conversão.

Equipes de Data Science

TecnologiaAutomatizem preparação de dados para modelos de ML, eliminando 80% do tempo gasto em limpeza e estruturação manual.

Departamentos Financeiros

FinanceiroConsolidem dados financeiros de múltiplas fontes para relatórios automáticos, análises de performance e compliance.

Gestores e Executivos

ExecutivoRecebam dashboards executivos atualizados em tempo real com KPIs críticos para tomada de decisão estratégica.

Equipes de Marketing

MarketingUnifiquem dados de campanhas, leads, conversões e ROI para otimização contínua de estratégias de marketing digital.

Analistas de Negócio

AnáliseAcessem dados limpos e estruturados para análises avançadas, relatórios automatizados e insights acionáveis.

Tipos de pipelines que desenvolvemos

Soluções personalizadas para diferentes necessidades de dados

Pipeline Batch

Processamento de grandes volumes de dados em lotes programados

Pipeline Streaming

Processamento em tempo real para dados críticos e alertas instantâneos

Pipeline Híbrido

Combinação de batch e streaming para máxima flexibilidade

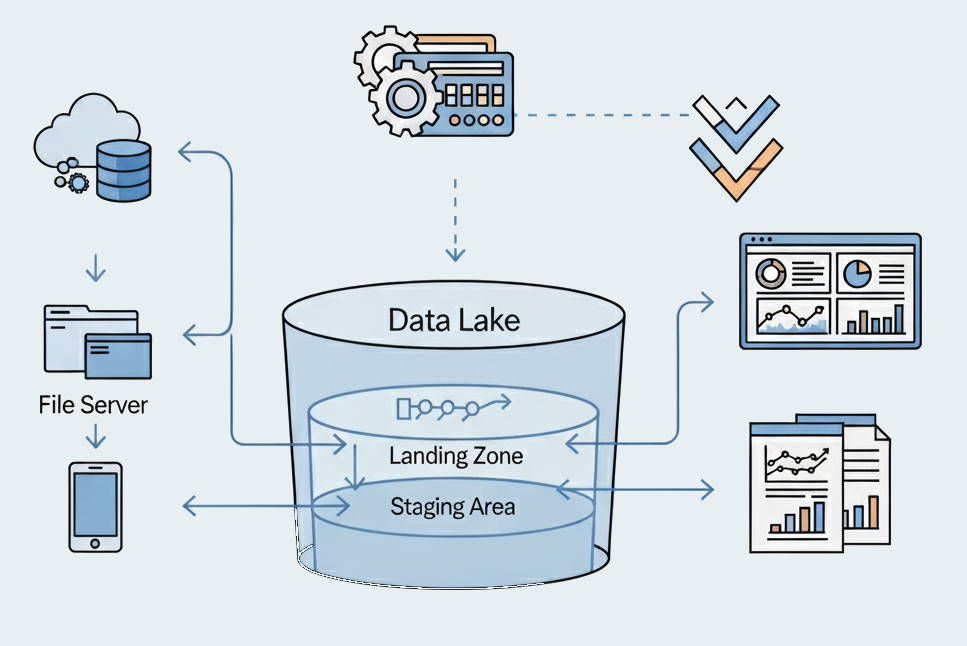

Data Lake Pipeline

Ingestão e organização de dados não estruturados em data lakes

API Integration Pipeline

Integração contínua com APIs externas e webhooks

ML Pipeline

Pipelines especializados para projetos de machine learning

Tecnologias que utilizamos

Stack moderno e consolidado para máxima performance e confiabilidade

Apache Airflow

Orquestração de workflows complexos e scheduling inteligente

Python & SQL

Linguagens líderes em data engineering e transformação

Cloud Platforms

AWS, Google Cloud, Azure para escalabilidade infinita

Docker & Kubernetes

Containerização e orquestração para alta disponibilidade

Apache Spark

Processamento distribuído para big data e analytics

Data Warehouses

BigQuery, Snowflake, Redshift para armazenamento otimizado

Fontes de dados que integramos

Conectamos qualquer fonte de dados ao seu pipeline

Bancos de dados relacionais

MySQL, PostgreSQL, SQL Server, Oracle

APIs e Webhooks

Integração com APIs REST, GraphQL e webhooks

Arquivos e Planilhas

CSV, Excel, JSON, XML, Parquet

Cloud Storage

AWS S3, Google Cloud Storage, Azure Blob

Sistemas ERP/CRM

Salesforce, SAP, Oracle, Microsoft Dynamics

Streaming de dados

Kafka, Kinesis, PubSub para dados em tempo real

Arquiteturas que implementamos

Padrões modernos para diferentes necessidades empresariais

Lambda Architecture

Processamento batch e real-time para máxima flexibilidade

Kappa Architecture

Streaming-first para dados críticos em tempo real

Data Mesh

Arquitetura descentralizada para grandes organizações

ELT Moderno

Extract, Load, Transform para data warehouses modernos

Recursos técnicos avançados

Tecnologia robusta para data engineering de classe empresarial

Monitoramento inteligente 24/7

Supervisão contínua com alertas automáticos sobre falhas, gargalos e anomalias nos dados processados.

Recuperação automática de falhas

Sistema inteligente de retry, checkpoints e recuperação automática para garantir processamento contínuo.

Validação automática de qualidade

Testes automáticos de qualidade, consistência e integridade dos dados em cada etapa do pipeline.

Escalabilidade horizontal

Arquitetura que escala automaticamente conforme volume de dados, sem intervenção manual.

APIs para integração

APIs REST completas para integração com sistemas existentes e dashboards customizados.

Logging e auditoria completa

Rastreabilidade completa de todos os dados processados para compliance e debugging avançado.

Agende consultoria gratuita

Nossos especialistas vão analisar suas necessidades e propor a arquitetura ideal de pipeline de dados.